| 论文英文名字 | Toward Cleansing Backdoored Neural Networks in Federated Learning |

|---|---|

| 论文中文名字 | 在联邦学习中清理后门神经网络 |

| 作者 | Chen Wu, Xian Yang, Sencun Zhu, Prasenjit Mitra |

| 来源 | 42nd ICDCS 2022: Bologna, Italy [CCF 计算机体系结构/并行与分布计算/存储系统 B 类会议] |

| 年份 | 2022 年 7 月 |

| 作者动机 | 修剪“后门神经元”可以大大减轻后门攻击,而不会损害太多的模型性能。但是,这些修剪方法不能直接用于联邦学习中。 |

| 阅读动机 | 了解训练后防御 剪枝 |

| 创新点 | 将神经元修剪用于联邦学习 |

内容总结

主要贡献

- 提出了两种联合剪枝方法

- 调整网络的极端权重

- 微调

问题定义

- 联邦学习:每个客户端样本数量相同、学习率相同、每一轮所有客户端都参与聚合(简化规则,加快攻击)

- 模型替换攻击

防御方法

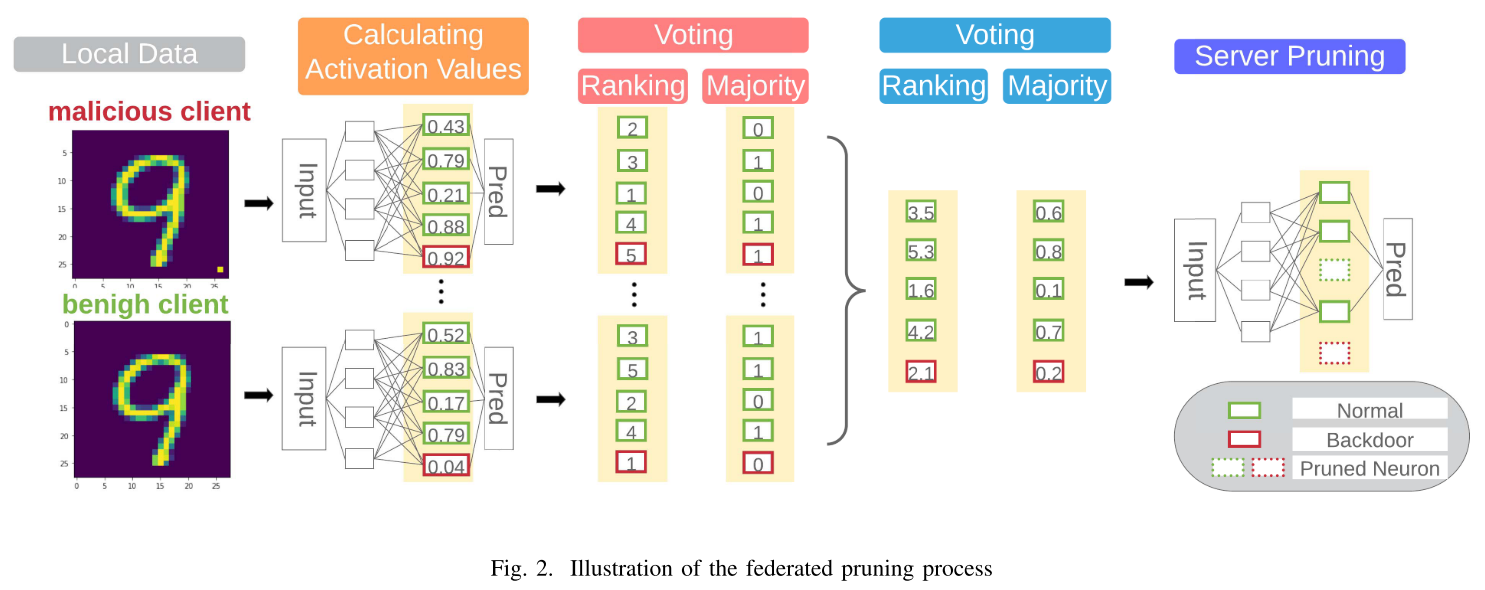

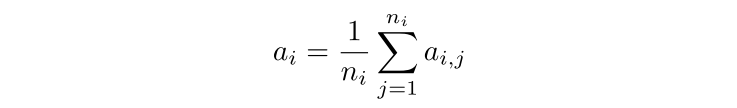

联合修剪

在 $L$ 层有一个有 $P_L$ 个“神经元”的前馈网络(最后的卷积层),每个神经元 $i\in[1,P_L] $ 都有一个输出 $a_i$,称为该神经元的激活值。

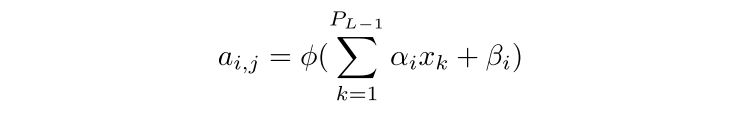

神经元 i 在样本 j 上的激活值:

所有训练样本的平均值:

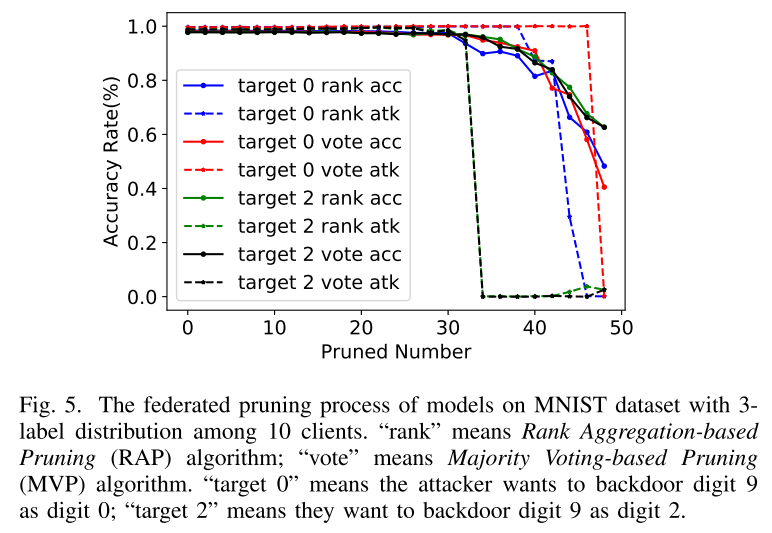

服务器聚合所有客户端的激活值,对激活值较小的神经元进行剪枝。(当主任务准确率降到阈值时,剪枝停止)由于联邦学习中服务器没有验证集,所以作者提出了以下方法:服务器可以将全局剪枝序列传回每个客户端,并要求他们报告测每个客户端在不同修剪率下的数据集测试准确性。服务器收集此反馈并确定最终的修剪策略。

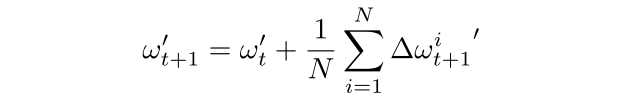

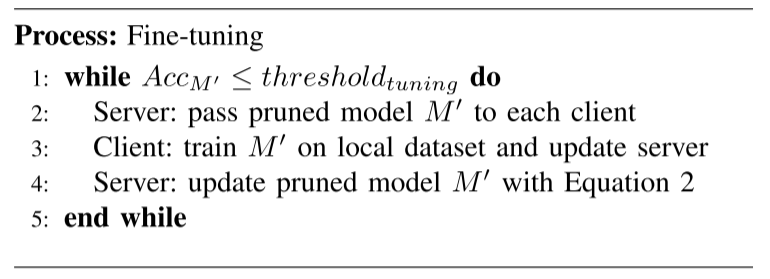

微调

问题:修剪神经元会导致模型在主要任务上的测试精度下降。

方法:将修剪后的模型发给客户端进行再训练,直到主要任务模型精度达到阈值。

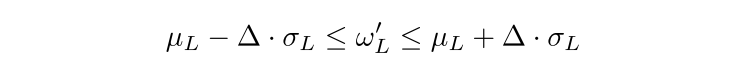

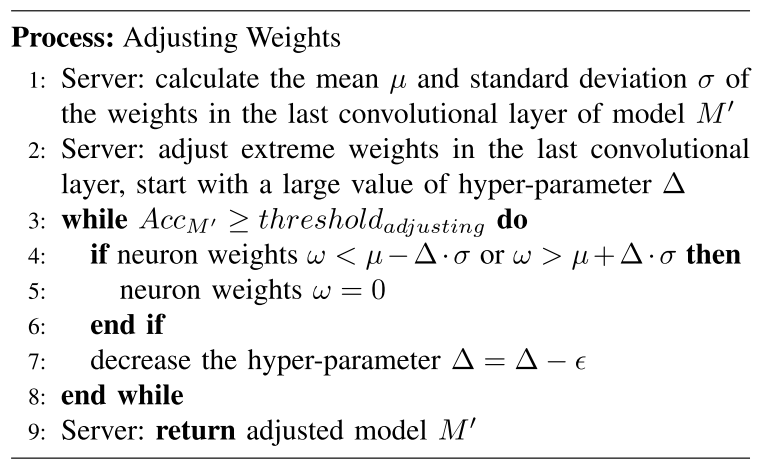

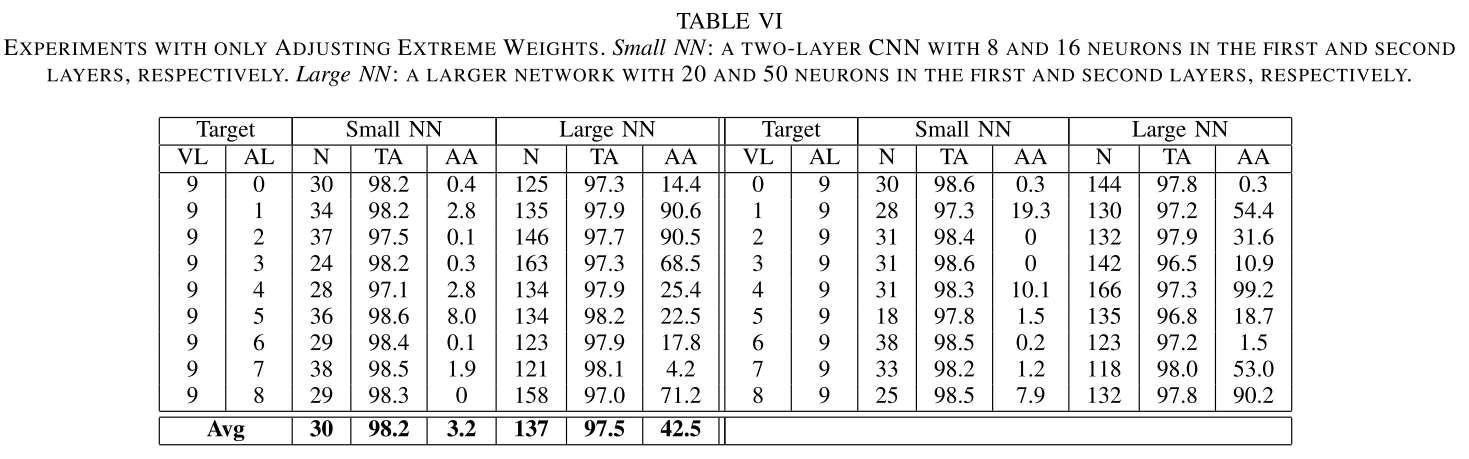

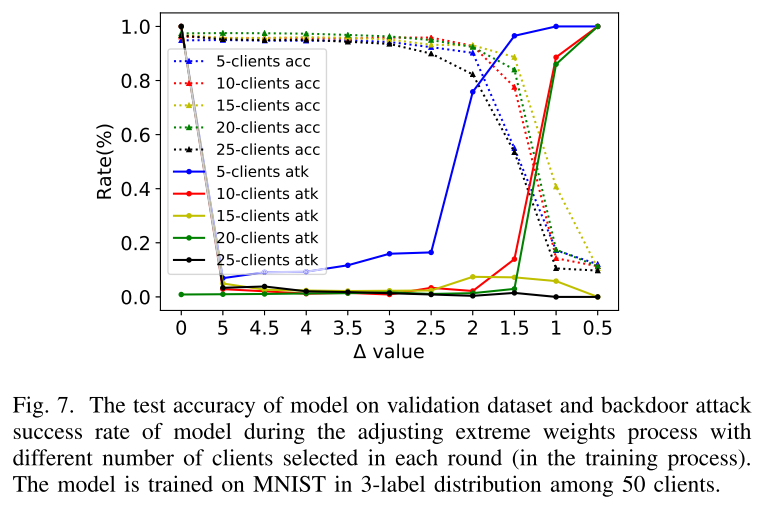

调整极端权重

问题:剪枝方法不能保证缓解后门攻击。此外,微调过程会将攻击成功率推回到高水平

动机:当支持正确标签的神经元/特征的数量多于支持后门标签的神经元/特征的数量时,恶意客户端必须引入输入的极值或神经元权重的极值以将正确的预测结果反转为后门标签。因此,通过限制神经元的输入和权重,我们可以减轻后门攻击。

方法:扫描最后一个卷积层中的所有权重,并根据该层权重的均值和标准差将大于或小于阈值的权重归零。

实验

- 数据集:MNIST、Fashion-MNIST 和 CIFAR-10

- 数据分布:non-iid

- 学习模型:两个卷积层、两个全连接层和三个卷积层和两个全连接层 和 VGG11

实验结果

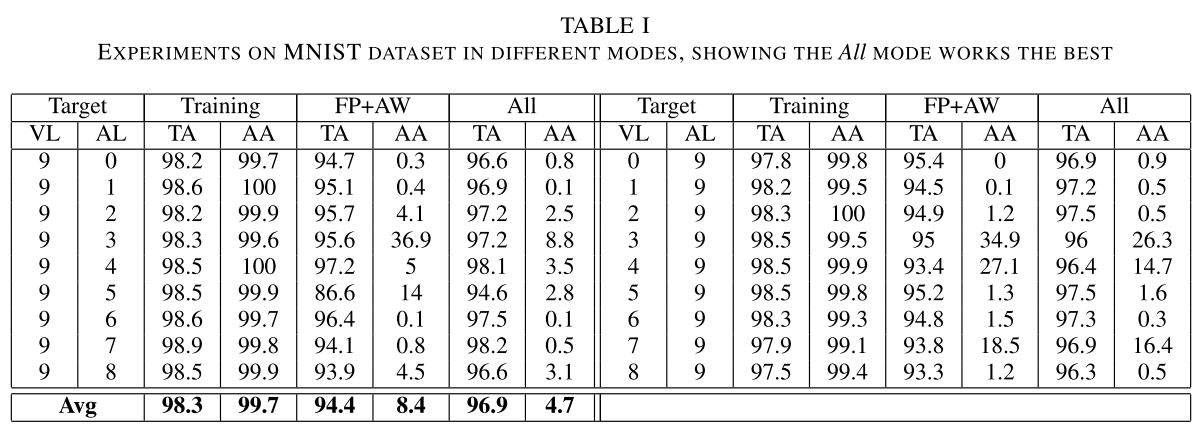

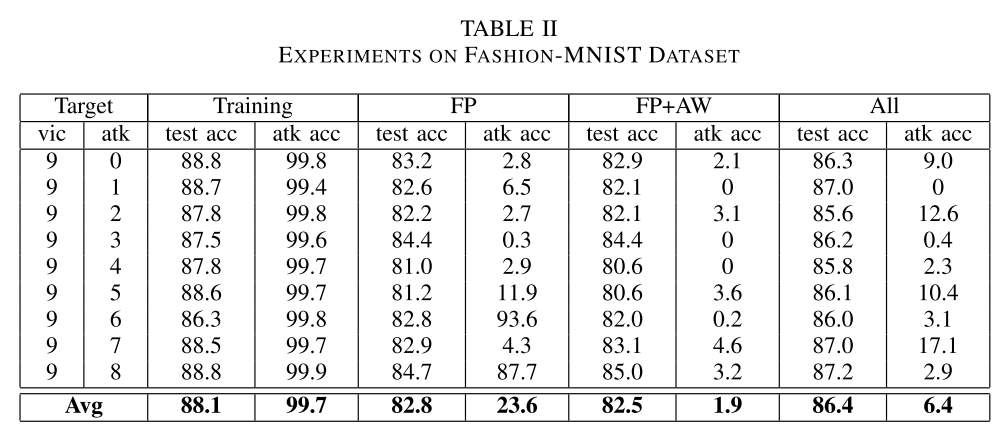

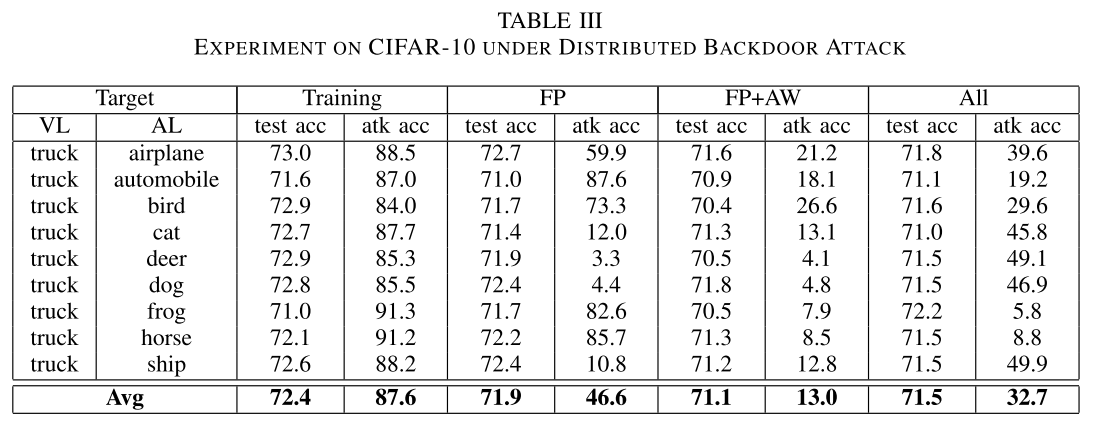

防御方法在三个数据集上的效果:

各个组件的效果:

总结

- 本文使用联合修剪方法、联合微调过程和调整神经网络的极端权重值来减轻训练阶段后的后门攻击。

- 可以防御模型替换和分布式后门攻击

- 防御效果感觉不是很好,微调的效果不是很明显