| 论文英文名字 | Dynamic Backdoor Attacks Against Machine Learning Models |

|---|---|

| 论文中文名字 | 针对机器学习模型的动态后门攻击 |

| 作者 | Ahmed Salem, Rui Wen, Michael Backes, Shiqing Ma, Yang Zhang |

| 来源 | EuroS&P 2022: Genoa, Italy [会议等级] |

| 年份 | 2022 年 6 月 |

| 作者动机 | 当前的后门技术依赖于在 ML 模型输入上添加静态触发器(具有固定的模式和位置),这些触发器很容易被当前的后门检测机制检测到。 |

| 阅读动机 | (1)解决触发器位置的相关问题(2)了解机器学习中的后门攻击 |

| 创新点 | 提出了针对深度神经网络(DNN)的第一类动态后门技术 |

内容总结

主要贡献

- 通过引入动态后门攻击,拓宽了针对深度神经网络(DNN)模型的后门攻击类别。

- 提出了后门生成网络(BaN)和条件后门生成网络(c-BaN),这是第一个算法后门范例。

- 动态后门攻击实现了强大的性能,同时绕过了当前最先进的后门防御技术。

动态后门

随机后门

方法:通过从均匀分布中采样触发器并将它们添加到随机位置的输入来构造触发器。

单个目标标签:构造了一组触发器($\mathcal{T}$)和一组可能的位置($\mathcal{K}$),使得对于从 $\mathcal{T}$ 采样并在从 $\mathcal{K}$ 采样的随机位置添加到任何输入的任何触发器,模型将输出指定的目标标签。

多个目标标签:对于任何标签 $\ell_i\in\mathcal{L}$,都存在一个触发器 $t$,当它在位置 $\kappa$ 处添加到输入 $x$ 时,将使模型 $\mathcal{M}_{bd}$ 输出 $\ell_i$。

问题:没有位置可以用于一个以上的目标标签。

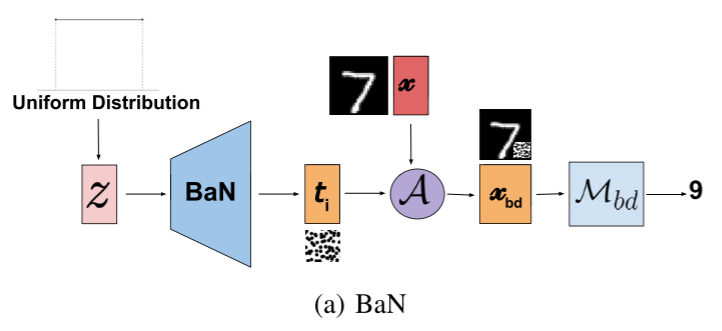

后门生成网络(BaN)

问题:随机后门技术不会搜索最佳触发器来实施后门攻击。

动机:BaN 受到最先进的生成模型的启发,即生成对抗性网络(GANs)。

与 GANs 的区别:(1)它不生成图像,而是生成后门触发器。(2)使用目标模型而不是判别器来联合训练 BaN 的生成器,以学习(生成器)并实现(目标模型)后门触发器的最佳模式。

单个目标标签:

- 对手通过将干净的数据查询到后门模型

$\mathcal{M}_{bd}$来开始每个训练时期。然后,他们计算地面真相和输出标签之间的干净损失。我们将交叉熵损失用于我们的干净损失$\varphi_c$,其定义如下:$\sum_i y_i log(\hat{y}_i)$ - 生成 n 个噪声向量

- 在 n 个噪声向量的输入上,BaN 生成 n 个触发器

- 攻击者通过使用后门添加功能 A 将生成的触发器添加到干净数据来创建后门数据。

- 将后门数据查询到后门模型

$\mathcal{M}_{bd}$,并计算模型输出和目标标签上的后门损失$\varphi_{bd}$。与干净损失类似,我们使用交叉熵损失作为$\varphi_{bd}$的损失函数。 - 攻击者使用干净和后门损失

$\varphi_c + \varphi_{bd}$更新后门模型$\mathcal{M}_{bd}$,并使用后门损失$\varphi_{bd}$更新 BaN。

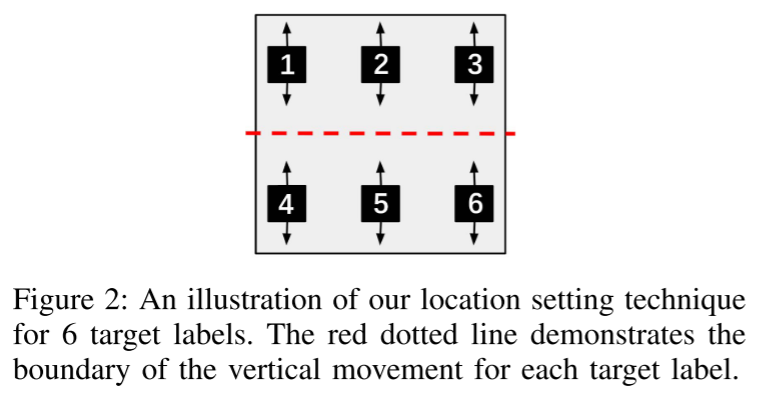

多个目标标签:(依赖触发器的位置来确定输出标签)

- 对手首先为所有目标标签创建不相交的位置集。

- 为每个目标标签重复第 2 步到第 5 步,并将所有后门损失加在一起。更正式地说,对于多目标标签情况,后门损失定义为:

$\sum_i^{|\mathcal{L}'|}\varphi_{bd_i}$,其中$\mathcal{L}'$是目标标签的集合,而$\varphi_{bd_i}$是目标标签$\ell_i$是后门损失。

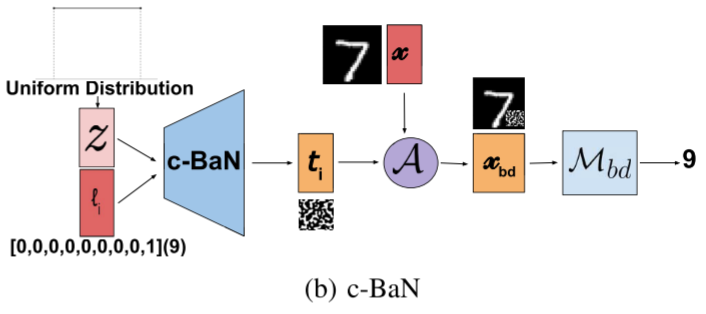

条件后门生成网络(c_BaN)

问题:以上两种技术都具有没有标签特定触发器的限制,并且仅依赖于触发器位置来确定目标标签。

区别:(1)不必为所有目标标签创建不相交的位置集;(2)将标签的独热编码添加到输入

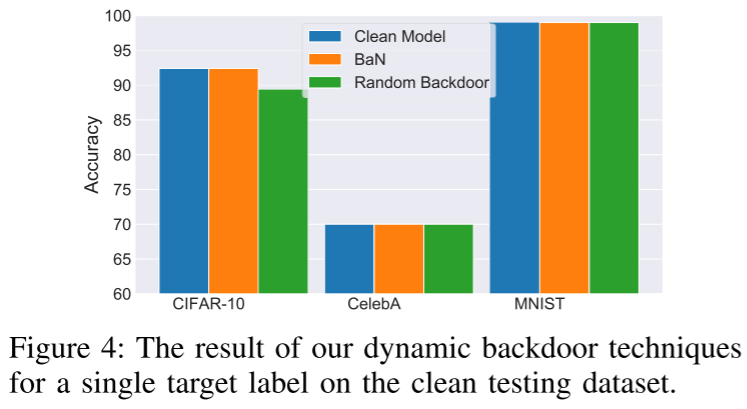

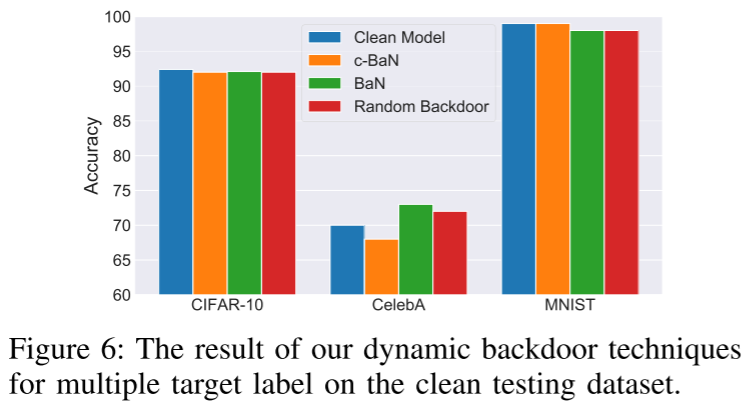

实验

- 数据集:MNIST、CelebA 和 CIFAR-10

- 评估指标:后门成功率和模型效用

攻击评估

对于所有三个数据集上的单个和多个目标标签案例,后门成功率始终是 100% 的。

不同超参数

后门数据的比例:使用 30% 已经足以获得一个完美运行的动态后门 位置数量:不影响攻击效果 触发器大小:触发器越小,模型实现后门行为的难度就越大。小的触发器会混淆模型,从而降低模型的效用。 触发器的透明度:当设置为 0.5 或更高时,攻击效果最好。

总结

- 当前的后门攻击只考虑模式和位置方面的静态触发器, 本文提出了第一组针对深度神经网络(DNN)模型的动态后门攻击,其中触发器可以具有多种模式和位置。

- 机器学习中的一些防御和攻击也是适用于联邦学习的,设计防御和攻击时还是要考虑联邦学习的特性。