| 论文英文名字 | PrivFL: Practical Privacy-preserving Federated Regressions on High-dimensional Data over Mobile Networks |

|---|---|

| 论文中文名字 | PrivFL:移动网络上高维数据的实用隐私保护联合回归 |

| 作者 | Kalikinkar Mandal, Guang Gong |

| 来源 | CCSW@CCS 2019: London, UK |

| 年份 | 2019年11月 |

| 作者动机 | 解决联邦学习中的模型隐私保护问题 |

| 阅读动机 | |

| 创新点 | (1)安全聚合缩放(2)分享局部梯度 |

内容总结

主要贡献

- 提出了 Dropout-robust 回归训练协议

- 在三种不同的威胁模型中证明了训练协议的安全性,以对抗模拟范式中的半诚实对手

- 实验评估

预备知识

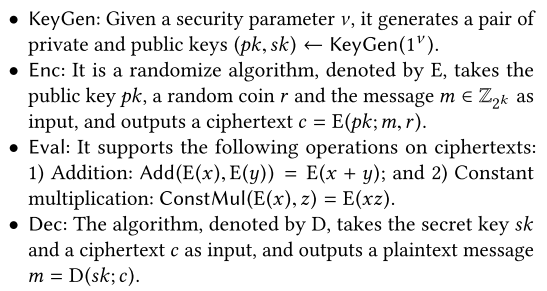

加法同态加密:一个加法同态加密(HE)方案由一个四元组组成, $HE=(KeyGen,Enc,Eval,Dec)$。同态加密(Homomorphic Encryption,HE)指将原始数据经过同态加密后,对密文进行特定的运算,得到的密文计算结果在进行同态解密后的得到的明文等价于原始明文数据直接进行相同计算所得到的数据结果。

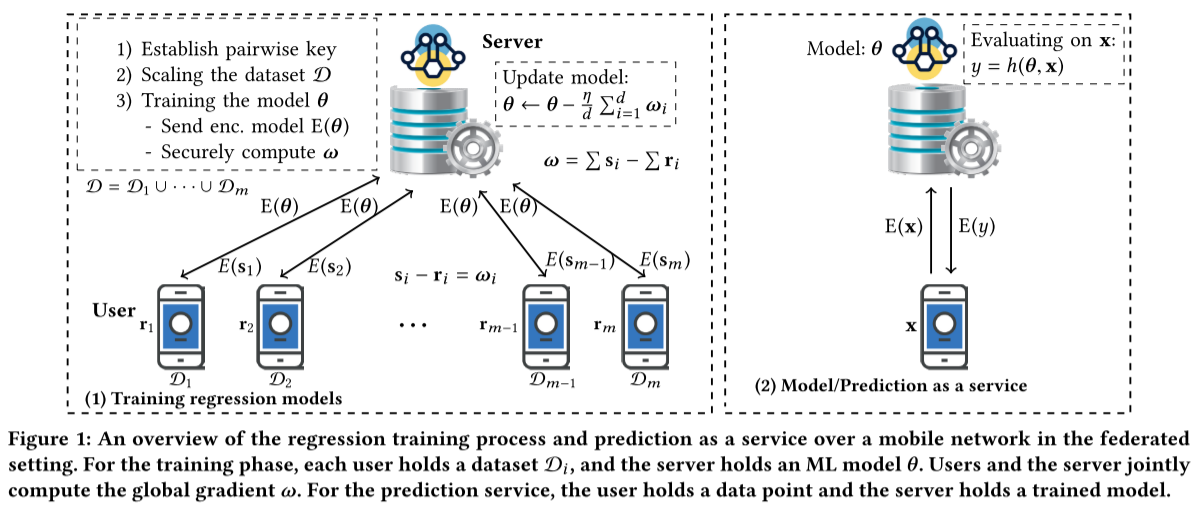

系统模型和目标

-

系统模型

系统中有 m 个用户和 1 个服务器,每个用户有一个数据集。

-

系统目标

- Dropout-robust 安全回归训练:使服务器能够在组合数据集上训练回归模型

$\theta$,同时允许用户在系统中随时退出,并确保移动用户的输入隐私和服务器的模型隐私。 - 不经意预测:使移动用户学习在其私有输入上的预测输出

$y$,对应于回归模型$\theta$,而不向服务器泄露$x$和不向用户泄露关于$\theta$的任何信息。

- Dropout-robust 安全回归训练:使服务器能够在组合数据集上训练回归模型

回归协议

主要目标:为基于适合移动设备的加密原语的回归模型开发安全的训练协议,并且对用户掉线场景具有鲁棒性。

- Dropout-robust 安全缩放操作

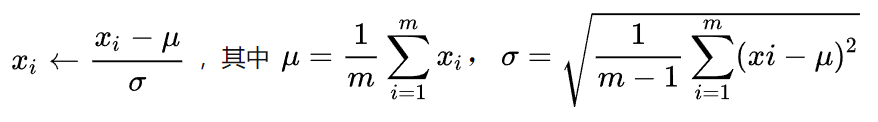

对于给定大小为 m 的集合 $\{x_i\}$ 进行 scaling 操作,简单来说就是

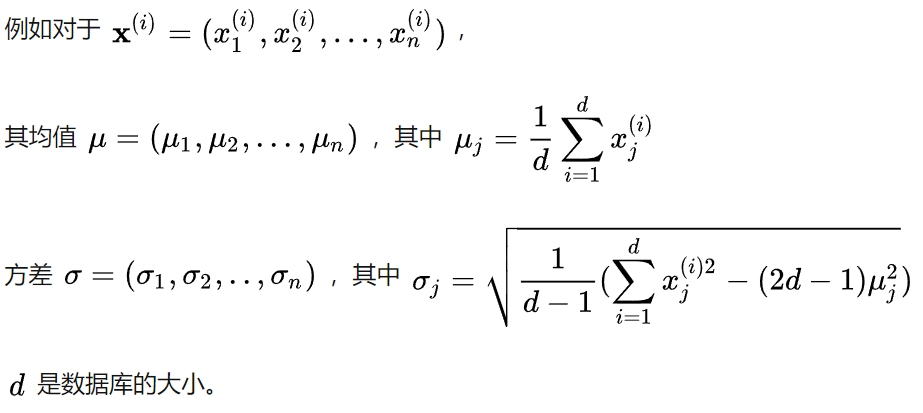

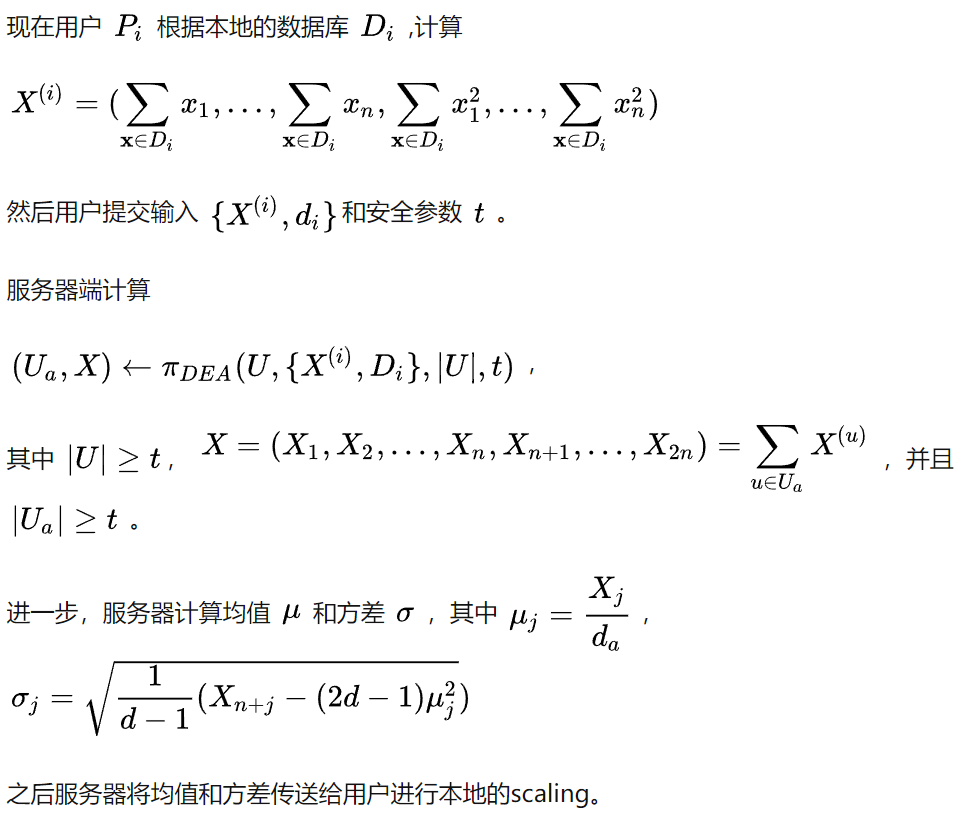

而对于高维的数据来说,例如数据集 $D=D_1 \cup D_2\cup\ldots \cup D_m$,scaling 便是对于每一个数据点进行操作。

适用于联邦学习的安全缩放操作

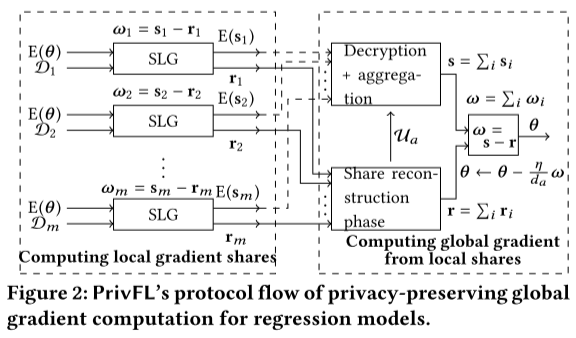

- 整体思路

每次训练的时候,服务器将模型同态加密。然后加密的模型传输到用户,用户利用同态的性质训练完之后得到密文梯度 $E({\omega}_i)$ 。之后用户生成 $E(s_i),r_i$ 满足 ${\omega}_i = s_i - r_i$。然后将 $E(s_i)$ 返回给服务器,服务器解密得到 $s_i$ 并将其聚合 $s=\sum_i s_i$。

而对于 $r_i$,用户将使用安全聚合协议得到 $r=\sum_i r_i$。

其中和之前的方案的最大不同点在于在聚合 $r_i$ 的时候会再次检测一次目前在线的用户,并将检测结果发送给聚合 $s_i$ 的部分,从而增加的了协议的灵活性。因为这样一来,在每次训练的时候不用事先确定在线的用户,只需要在恢复阶段确定在线的用户即可。

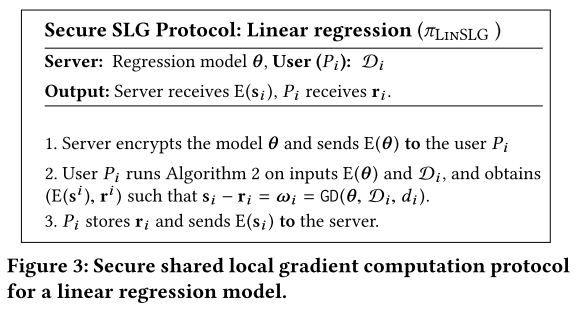

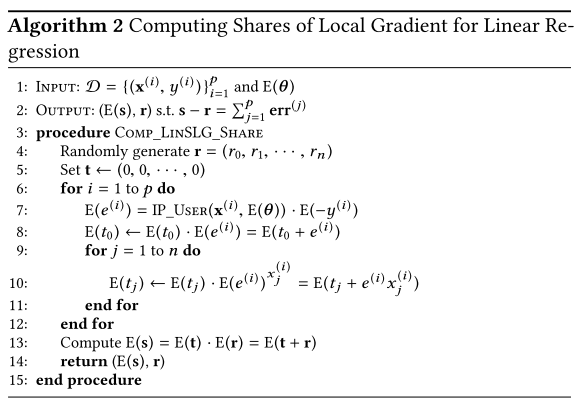

现在问题的重点便是如何实现 SLG。对于线性回归,我们想要实现的功能如下所示:

算法 2 如下所示

其中 IP_USER 求向量内积,$t$ 用来存储加密的梯度。

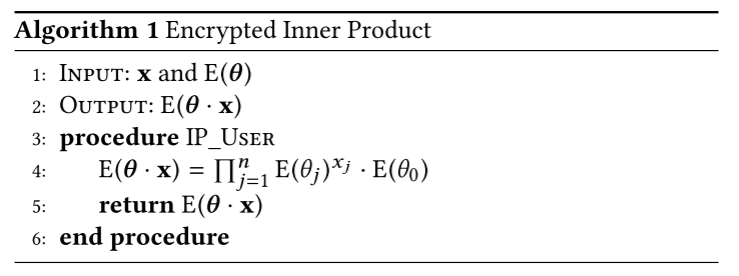

而 IP_USER 算法如下:

而对于 logistic 回归的训练,则会牵扯到非线性函数 sigmoid 函数。在此,作者采用了惯用的手段——用多项式近似。近似用的多项式是$${\sigma}_3(x)=q_0+q_1x+q_2x^2+q_3x^3$$具体协议和线性回归没有太大区别。

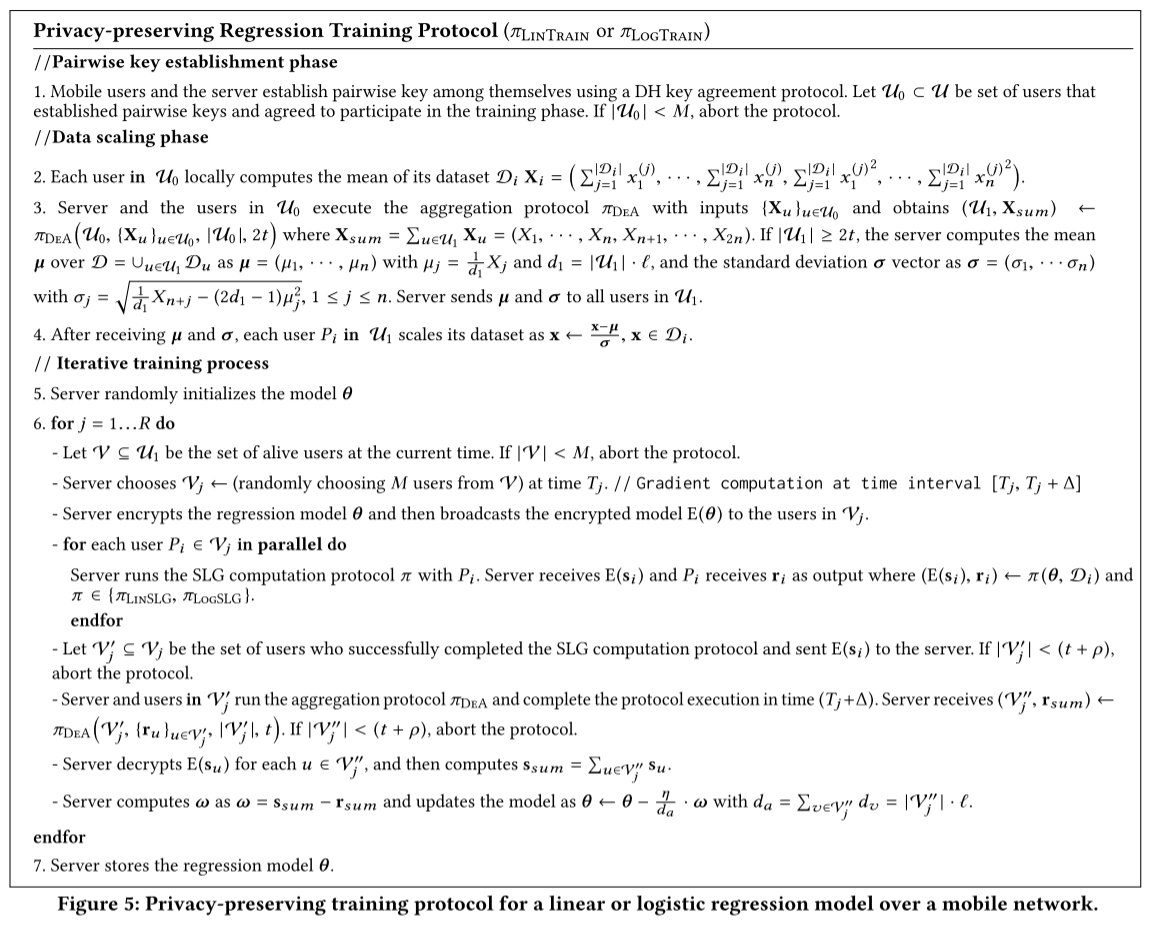

隐私保护回归训练协议如下图所示

训练协议在服务器和同步网络中的一组用户之间执行,分为三个阶段:1)成对密钥建立阶段,2)数据集缩放阶段,3)通过迭代计算用户数据子集的全局梯度来计算回归模型。

全局梯度计算过程:

1. 服务器随机选择一组M个用户,将当前的加密模型广播给这些用户,

2. 服务器和每个用户并行计算所选用户数据集上的本地梯度的两个份额,

3. 服务器和活动用户从活动用户的本地梯度份额中计算单个(聚合)份额,

4. 服务器从其本地份额计算全局梯度的第二份额,然后恢复全局梯度以更新模型。

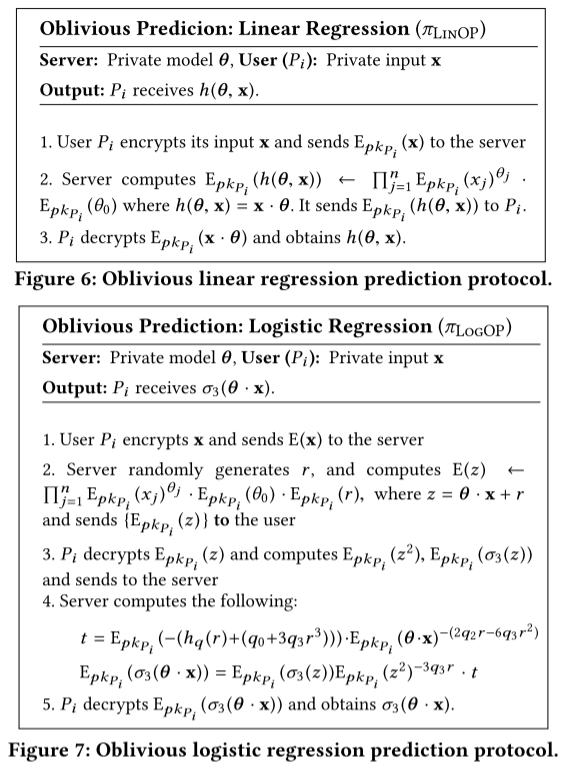

不经意预测的功能,则是用户将数据同态加密之后发送给服务器,服务器用模型计算一个加密的标签之后返回给用户解密即可。

性能分析

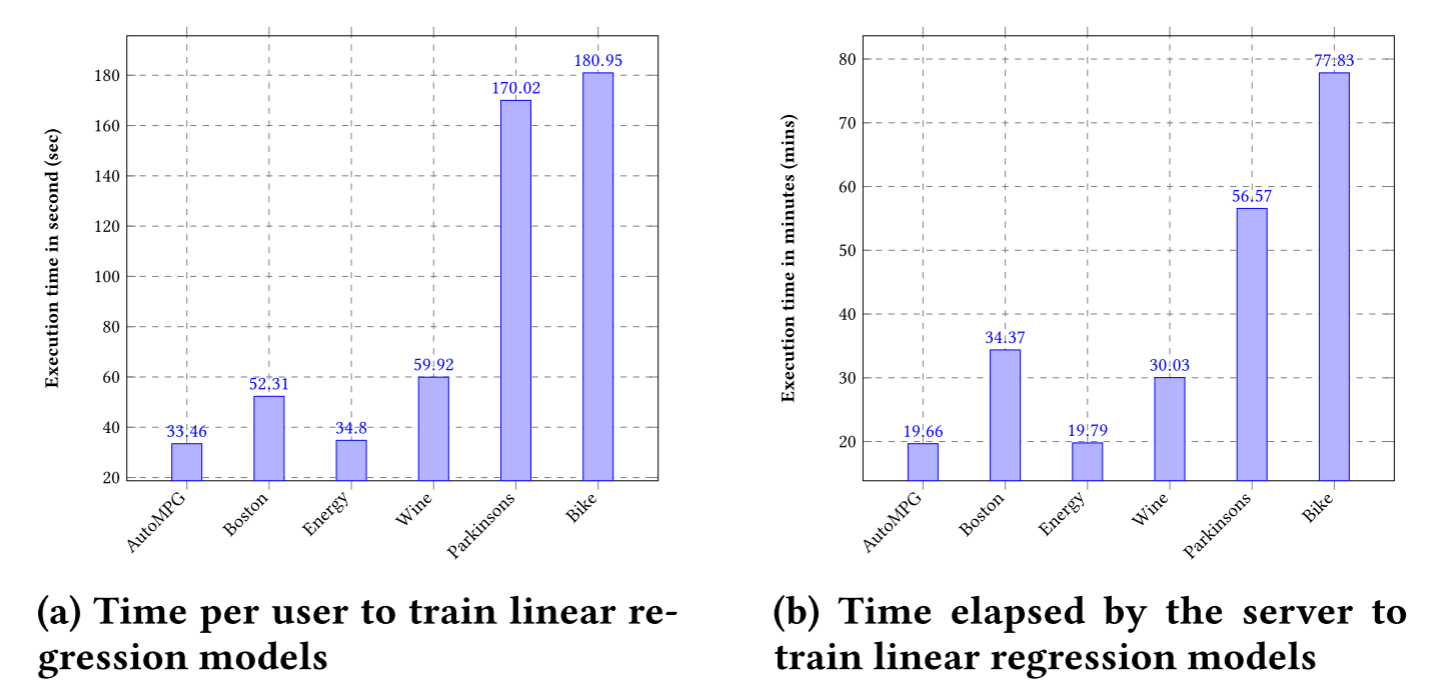

- 线性回归模型训练性能

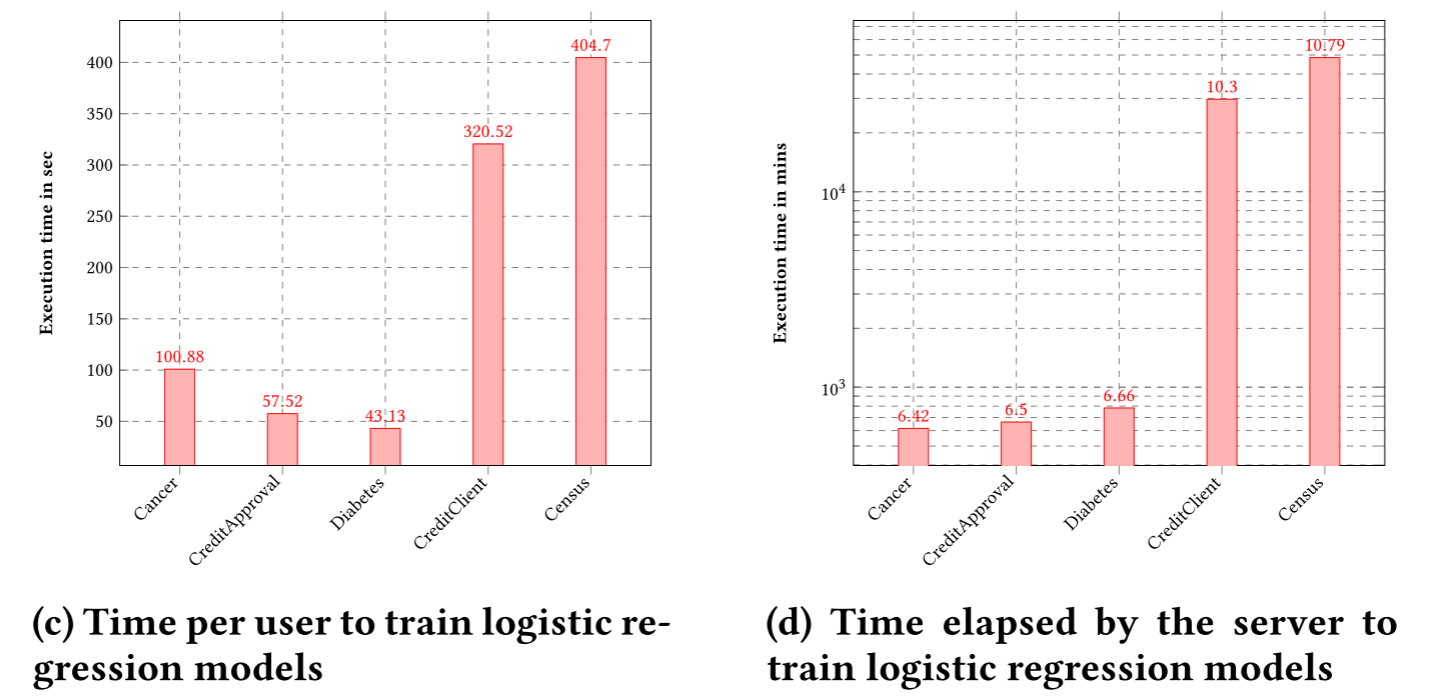

- 逻辑回归模型训练性能

总结

本文介绍了 PrivFL,这是一个隐私保护系统,用于在联邦设置中对预测模型(例如线性和逻辑回归)进行训练和不经意预测,同时确保 dropout 鲁棒性和数据以及模型隐私。PrivFL 通过迭代执行使用适用于移动应用程序的轻量级密码原语构建的安全多方全局梯度协议,实现了稳健且安全的训练过程。针对半诚实的对手分析 PrivFL 的安全性。我们在几个真实世界数据集上的实验结果证明了 PrivFL 融入联邦学习系统的实用性。

我们打算在智能手机上实施 PrivFL 以评估其效率。由于当今的服务器平台配备了多个 CPU,我们正在努力在服务器端设计一个简单且并行的实现接口,以减少计算时间。在保持第 4.2 节中的一般协议流程相同的同时,我们将在另一篇论文中将我们的工作扩展到神经网络。作为未来的工作,调查用户异步参与训练阶段的情况会很有趣。

参考

- 联邦学习入门(二)-Practical Secure Aggregation for Privacy-Preserving Machine Learning论文算法详解

- 论文阅读-Practical Secure Aggregation for Privacy-Preserving Machine Learning

- Secure Aggregation

会议记录

- 规划讲述流程

- 英文截图可以加中文注释

- 下载论文,调查方向人数情况和可以做的方向